根据最佳实践做法,Management、vMotion、vSphereFT、iSCSI等的网络相互隔离,从而提高安全性和性能。同时每个网络建议配置2块物理网卡用作冗余和负载均衡,根据最佳实践可能至少需要6块网卡,多则十几块网卡,这对标配4块网卡的机架式服务器是不现实的。

分类: VMware学习

VMware NSX+Avi:打通从 CI 到 CD 的“最后一公里”

产品介绍:

NSX:

来自 VMware 在 2012 年收购的 SDN 鼻祖公司 Nicira,现在已经是非常成熟的解决方案了,有广泛的客户在生产环境中使用。

NSX 可以打通物理网络的孤岛,抽象出网元,通过转控分离的 SDN 架构实现一致的网络功能,甚至打通多中心、多云环境,实现整个虚拟网络在多云、多中心一致的网络和安全策略。现在它可以针对容器环境实现 Pod 层面的全网可路由、为特定应用确定固定的 IP 地址段、并将安全微分段细化到 Pod 层面。

Avi:

Avi 的正式名称是 NSX Advanced Load Balancer(简称为 NSX-ALB),它来自 VMware 于 2019 年收购的纯软件 ADC(应用交付控制器,俗称负载均衡)公司——Avi Networks,因此我们一般俗称这个产品叫做 Avi。

和 NSX 一样,Avi 同样采用了基于 SDN 的转控分离的架构,配置和部署就变得非常简单,且能实现资源池,有很好的弹性以及自愈的架构,消除了竖井式的 ADC 架构。它还自带 GSLB(广域网负载均衡)、WAF(Web 应用防火墙)、多租户、应用可视化与分析等诸多丰富的功能。针对容器环境,还能同时实现容器 ingress(入向路由)、服务暴露。

在介绍 VMware NSX+Avi 的产品组合是如何打通从 CI 到 CD 的“最后一公里”之前,我们首先来谈一谈什么是 CI、CD,以及为什么从 CI 到 CD 阶段是存在潜在的障碍和瓶颈的。

ESXI | 6.7-7.0如何强制直通板载USB芯片组

我这里以我们的all in one主板为例,我们主板,查找USB设备时,可以看到有两个芯片组,一个是板载的不能原生直通,一个是可以原生直通的,现在我就来演示如何把不能原生直通的这个USB芯片开启直通。

VMware NSX-V与NSX-T的比较(转载&翻译)

当今虚拟化领域中最令人兴奋的技术领域之一是软件定义网络(SDN)。软件定义的网络或SDN确实在改变着我们所知道的网络格局,并创造了一个世界,在该世界中,物理网络只是一个底层环境,在其上交换和路由虚拟网络数据包。

VMware的NSX是软件定义的网络解决方案,可完全通过软件提供虚拟化网络和安全性。

它是当今市场上最重要的企业数据中心SDN解决方案,它允许企业通过提供灵活的控件和技术解决方案来满足当今快速发展的网络需求,从而使企业数据中心实现现代化。如今,使用VMware NSX,需要注意该产品的两个变体。它们是NSX-V和NSX-T。

继续阅读ESXi6.5中将虚拟机从厚置备转换为精简置备

用ESXi做虚拟化,创建了一个原始虚拟机并安装好系统做好基本设置,使用ESXi的web界面复制虚拟机,结果后来发现复制出来的都是厚置备,导致占用大量空间。

网上找到一篇教程,但不够清晰,遂有此文。

继续阅读WorkStation虚拟机迁移到 ESXi

Esxi虚拟机OVF导出问题解决方法

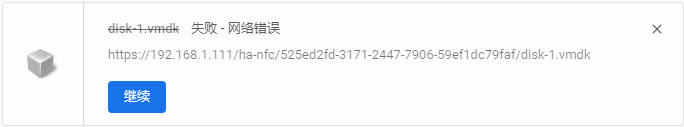

1.问题描述:最近搞VMWare-Esxi(企业版服务器虚拟机管理操作系统),通过Esxi导出CentOS镜像OVF文件导出失败,该问题花费N多脑细胞,总结如下。

2.问题表象:遇到 disk-1.vmdk失败 – 网络错误

如图所示

VMware ESXI中开放VNC功能及端口实现远程管理

在多个论坛上看了相关文章,总的写得不完整。现将各方资源整编写完整版。详文如下!

继续阅读